SqueezeNet是一种小巧而精确的算法,它在高精度和低复杂度之间达到了很好的平衡,因此非常适合资源有限的移动和嵌入式系统。

2016年,DeepScale、加州大学伯克利分校和斯坦福大学的研究人员提出了一种紧凑高效的卷积神经网络(CNN)——SqueezeNet。近年来,研究人员对SqueezeNet进行了多次改进,其中包括SqueezeNet v1.1和SqueezeNet v2.0。这两个版本的改进不仅提高了准确性,还降低了计算成本。 SqueezeNet v1.1在ImageNet数据集上的精度提高了1.4%,而SqueezeNet v2.0的精度提高了1.8%。同时,这两个版本的参数数量减少了2.4倍。这意味着SqueezeNet能够在保持高准确性的同时,减少了模型的复杂度和计算资源的需求。 由于SqueezeNet的紧凑设计和高效运算,它在计算资源受限的场景中具有很大的优势。这使得SqueezeNet成为在边缘设备和嵌入式系统中应用深度学习的理想选择。通过不断改进和优化,SqueezeNet为实现高效的图像分类和目标检测任务提供了一种可行的解决方案。

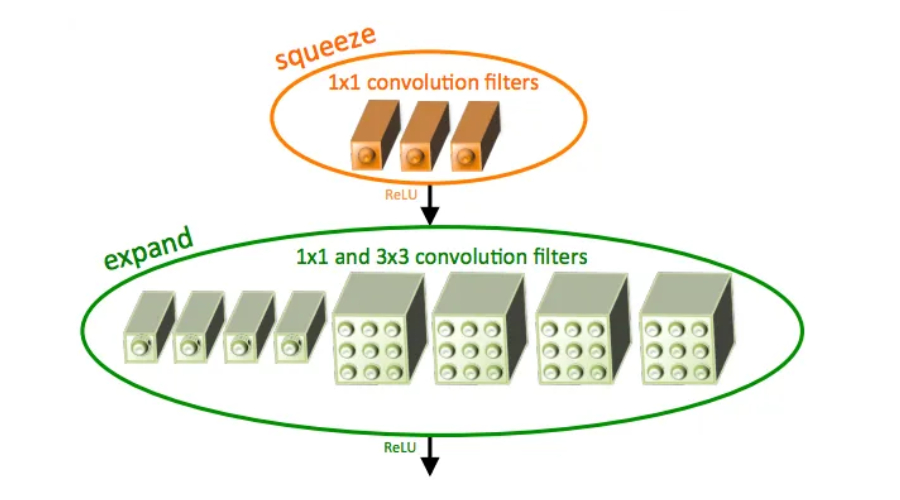

SqueezeNet采用fire模块,这是一种特殊类型的卷积层,它融合了1x1和3x3滤波器,有效减少了参数数量,同时保持高精度,使其成为资源受限设备的理想选择。它能够在使用其他CNN所需的仅有一小部分计算资源的情况下实现高度精确的结果。

SqueezeNet的一个主要优势在于它在准确性和计算资源之间取得了平衡。相比于AlexNet,SqueezeNet的参数数量减少了50倍,每秒浮点运算(FLOPS)的需求减少了10倍。因此,它能够在计算资源有限的边缘设备上运行,例如手机和物联网设备。这种高效性使得SqueezeNet成为在资源受限环境下进行深度学习的理想选择。

SqueezeNet采用了一种名为通道挤压的方法,这是该技术的主要创新之一。通过减少模型卷积层中的通道数量,SqueezeNet降低了网络计算成本,同时保持了准确性。除了fire modules和deep compression等其他方法,SqueezeNet还使用了通道压缩来提高效率。这种方法可以通过去除冗余的通道来减少模型的参数量,进而减少计算量,提高模型的运行速度。这种通道挤压的方法在保持模型精度的同时,有效地降低了网络的计算成本,使得SqueezeNet成为一种轻量级且高效的神经网络模型。

SqueezeNet与传统的CNN不同,它不需要大量的计算能力,可以与其他机器学习管道中的特征提取器配合使用。这使得其他模型能够从SqueezeNet学到的特征中受益,从而在移动设备上实现更高的性能。

SqueezeNet因架构创新、且证明可以提高性能而受到认可,现已被其他CNN架构广泛采用。